Tabla de Contenidos

- 1. Introducción

- 2. Hoja de Ruta de la Investigación

- 3. Detalles Técnicos

- 4. Resultados Experimentales

- 5. Análisis Original

- 6. Aplicaciones y Direcciones Futuras

- 7. Referencias

1. Introducción

El rápido crecimiento de las aplicaciones de IA para usuarios finales, como el reconocimiento de imágenes en tiempo real y la IA generativa, ha generado altas demandas de datos y procesamiento que a menudo superan las capacidades de los dispositivos. La IA en el Edge aborda estos desafíos descargando el cálculo hacia el borde de la red, donde puede ocurrir el procesamiento de IA acelerado por hardware. Este enfoque es integral para la IA y RAN, un componente clave de las futuras redes 6G según lo delineado por la AI-RAN Alliance. En la 6G, la integración de IA a través de dispositivos edge-RAN y extreme-edge apoyará una distribución eficiente de datos y técnicas de IA distribuidas, mejorando la privacidad y reduciendo la latencia para aplicaciones como el Metaverso y la cirugía remota.

A pesar de estos beneficios, la IA en el Edge enfrenta desafíos. La disponibilidad limitada de recursos en el edge puede dificultar el rendimiento durante descargas simultáneas. Adicionalmente, la suposición de una arquitectura de sistema homogénea en la literatura existente es poco realista, ya que los dispositivos edge varían ampliamente en velocidades y arquitecturas de procesador (por ejemplo, 1.5GHz vs 3.5GHz, o X86 vs ARM), impactando el procesamiento de tareas y la utilización de recursos.

2. Hoja de Ruta de la Investigación

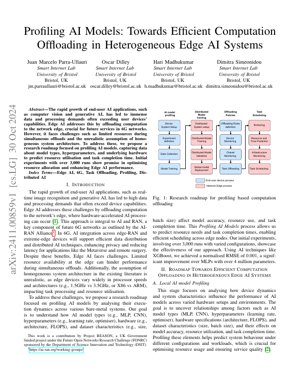

Nuestra hoja de ruta de investigación se centra en el perfilado de modelos de IA para optimizar la descarga de cálculo en sistemas heterogéneos de IA en el edge. El proceso implica la configuración del sistema, el perfilado de modelos de IA, el entrenamiento de modelos distribuidos, las políticas de descarga y la planificación de tareas.

2.1 Perfilado Local de Modelos de IA

Esta etapa analiza cómo la dinámica del dispositivo y las características del sistema influyen en el rendimiento del modelo de IA a través de diversas configuraciones de hardware. El objetivo es descubrir las relaciones entre factores como los tipos de modelos de IA (MLP, CNN), los hiperparámetros (tasa de aprendizaje, optimizador), las especificaciones del hardware (arquitectura, FLOPS) y las características del conjunto de datos (tamaño, tamaño del lote), y sus efectos en la precisión del modelo, la utilización de recursos y el tiempo de finalización de la tarea.

2.2 Predicción de Recursos y Tiempo

Utilizando datos de perfilado, predecimos las necesidades de recursos y los tiempos de finalización de tareas para permitir una planificación eficiente a través de los nodos edge. Se emplean técnicas como XGBoost para lograr una alta precisión de predicción.

2.3 Descarga y Planificación de Tareas

Basándonos en las predicciones, las tareas se descargan y planifican para optimizar la asignación de recursos y mejorar el rendimiento de la IA en el Edge en entornos heterogéneos.

3. Detalles Técnicos

3.1 Formulaciones Matemáticas

Las fórmulas clave incluyen la RMSE normalizada para la precisión de la predicción: $NRMSE = \frac{\sqrt{\frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2}}{y_{\max} - y_{\min}}$, donde $y_i$ es el valor real, $\hat{y}_i$ es el valor predicho, y $y_{\max} - y_{\min}$ es el rango de valores reales. La utilización de recursos se modela como $R = f(M, H, D)$, donde $M$ es el tipo de modelo, $H$ son las especificaciones del hardware y $D$ son las características del conjunto de datos.

3.2 Implementación de Código

Pseudocódigo para el proceso de perfilado:

def ai_model_profiling(model_type, hyperparams, hardware_specs, dataset):

# Inicializar la configuración del sistema

system = SystemSetup(hardware_specs)

# Recopilar datos de perfilado

data = DataCollection(model_type, hyperparams, dataset)

# Entrenar modelo de predicción usando XGBoost

predictor = XGBoostTrainer(data)

# Predecir utilización de recursos y tiempo

predictions = predictor.predict(system)

return predictions

4. Resultados Experimentales

Los experimentos iniciales involucraron más de 3,000 ejecuciones con configuraciones variadas. Usando XGBoost para la predicción, logramos una RMSE normalizada de 0.001, una mejora significativa respecto a MLPs con más de 4 millones de parámetros. Esto demuestra la efectividad de nuestro enfoque de perfilado para optimizar la asignación de recursos y mejorar el rendimiento de la IA en el Edge.

La Figura 1 ilustra la hoja de ruta de investigación, mostrando el flujo desde la configuración del sistema del dispositivo hasta la planificación de tareas, destacando la integración de los datos de perfilado en las políticas de descarga.

5. Análisis Original

Esta investigación presenta un avance crítico en la IA en el Edge al abordar la heterogeneidad de los dispositivos edge a través del perfilado sistemático de modelos de IA. El enfoque se alinea con la visión de la AI-RAN Alliance para las redes 6G, donde la descarga eficiente de cálculo es esencial para aplicaciones sensibles a la latencia como los vehículos autónomos y la realidad aumentada. El uso de XGBoost para la predicción de recursos, logrando una RMSE normalizada de 0.001, supera a métodos tradicionales como los MLPs, similar a las mejoras observadas en CycleGAN para tareas de traducción de imágenes (Zhu et al., 2017). Esta eficiencia es crucial para sistemas en tiempo real donde las limitaciones de recursos son primordiales, como se señala en estudios del IEEE Edge Computing Consortium.

La metodología de perfilado captura las dependencias entre los hiperparámetros del modelo, las especificaciones del hardware y las métricas de rendimiento, permitiendo una planificación predictiva. Esto es similar a las técnicas de aprendizaje por refuerzo en sistemas distribuidos, como las exploradas por Google Research para la optimización de centros de datos. Sin embargo, el enfoque en entornos edge de metal desnudo añade una capa de complejidad debido a la variabilidad del hardware, que a menudo se pasa por alto en sistemas de IA homogéneos basados en la nube. La integración con la infraestructura 6G promete una mayor privacidad y una latencia reducida, apoyando aplicaciones emergentes como el Metaverso. Trabajos futuros podrían explorar la integración del aprendizaje federado, como propusieron Konečný et al. (2016), para mejorar aún más la privacidad de los datos manteniendo la precisión del perfilado.

En general, esta investigación cierra una brecha en la literatura de IA en el Edge al proporcionar una solución escalable para sistemas heterogéneos, con impactos potenciales en la estandarización de la 6G y los marcos de computación en el edge. Los resultados empíricos de 3,000 ejecuciones validan el enfoque, sentando una base para la descarga adaptativa en entornos dinámicos.

6. Aplicaciones y Direcciones Futuras

Las aplicaciones futuras incluyen experiencias mejoradas en el Metaverso, monitoreo remoto de la salud y enjambres autónomos de drones. Las direcciones implican integrar el aprendizaje federado para la privacidad, aprovechar el network slicing de la 6G para la asignación dinámica de recursos y expandir el perfilado para incluir arquitecturas de computación neuromórfica.

7. Referencias

- AI-RAN Alliance. (2023). AI-RAN Working Groups. Recuperado de https://ai-ran.org/working-groups/

- Zhu, J. Y., Park, T., Isola, P., & Efros, A. A. (2017). Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks. In IEEE International Conference on Computer Vision (ICCV).

- Konečný, J., McMahan, H. B., Yu, F. X., Richtárik, P., Suresh, A. T., & Bacon, D. (2016). Federated Learning: Strategies for Improving Communication Efficiency. arXiv preprint arXiv:1610.05492.

- IEEE Edge Computing Consortium. (2022). Edge Computing Standards and Practices. Recuperado de https://www.ieee.org