Table des matières

- 1. Introduction

- 2. Feuille de route de la recherche

- 3. Détails Techniques

- 4. Résultats Expérimentaux

- 5. Analyse Originale

- 6. Applications Futures et Orientations

- 7. Références

1. Introduction

La croissance rapide des applications d'IA pour les utilisateurs finaux, telles que la reconnaissance d'images en temps réel et l'IA générative, a entraîné des exigences élevées en matière de données et de traitement qui dépassent souvent les capacités des appareils. L'IA en périphérie relève ces défis en déléguant le calcul vers la périphérie du réseau, où un traitement accéléré de l'IA par le matériel peut avoir lieu. Cette approche est intégrante à l'IA et au RAN, une composante clé des futurs réseaux 6G telle que décrite par l'AI-RAN Alliance. Dans la 6G, l'intégration de l'IA à travers les dispositifs edge-RAN et extreme-edge soutiendra une distribution efficace des données et des techniques d'IA distribuée, améliorant la confidentialité et réduisant la latence pour des applications comme le Métavers et la chirurgie à distance.

Malgré ces avantages, l'IA en périphérie fait face à des défis. La disponibilité limitée des ressources en périphérie peut entraver les performances lors de délégations simultanées. De plus, l'hypothèse d'une architecture système homogène dans la littérature existante est irréaliste, car les dispositifs en périphérie varient considérablement en termes de vitesses de processeur et d'architectures (par exemple, 1,5 GHz contre 3,5 GHz, ou X86 contre ARM), ce qui impacte le traitement des tâches et l'utilisation des ressources.

2. Feuille de route de la recherche

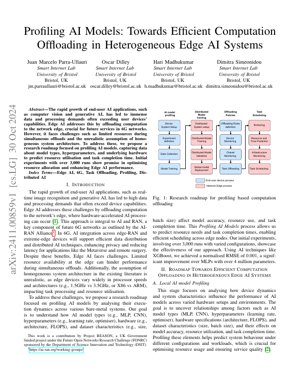

Notre feuille de route de recherche se concentre sur le profilage des modèles d'IA pour optimiser la délégation de calcul dans les systèmes hétérogènes d'IA en périphérie. Le processus implique la configuration du système, le profilage des modèles d'IA, l'entraînement distribué des modèles, les politiques de délégation et l'ordonnancement des tâches.

2.1 Profilage Local des Modèles d'IA

Cette étape analyse comment la dynamique des appareils et les caractéristiques du système influencent les performances des modèles d'IA sur diverses configurations matérielles. L'objectif est de découvrir les relations entre des facteurs tels que les types de modèles d'IA (MLP, CNN), les hyperparamètres (taux d'apprentissage, optimiseur), les spécifications matérielles (architecture, FLOPS) et les caractéristiques des jeux de données (taille, taille de lot), et leurs effets sur la précision du modèle, l'utilisation des ressources et le temps d'exécution des tâches.

2.2 Prédiction des Ressources et du Temps

En utilisant les données de profilage, nous prédisons les besoins en ressources et les temps d'exécution des tâches pour permettre un ordonnancement efficace entre les nœuds périphériques. Des techniques comme XGBoost sont employées pour atteindre une haute précision de prédiction.

2.3 Délégation et Ordonnancement des Tâches

Sur la base des prédictions, les tâches sont déléguées et ordonnancées pour optimiser l'allocation des ressources et améliorer les performances de l'IA en périphérie dans des environnements hétérogènes.

3. Détails Techniques

3.1 Formulations Mathématiques

Les formules clés incluent la RMSE normalisée pour la précision de prédiction : $NRMSE = \frac{\sqrt{\frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2}}{y_{\max} - y_{\min}}$, où $y_i$ est la valeur réelle, $\hat{y}_i$ est la valeur prédite, et $y_{\max} - y_{\min}$ est l'étendue des valeurs réelles. L'utilisation des ressources est modélisée comme $R = f(M, H, D)$, où $M$ est le type de modèle, $H$ sont les spécifications matérielles et $D$ sont les caractéristiques du jeu de données.

3.2 Implémentation du Code

Pseudocode pour le processus de profilage :

def ai_model_profiling(model_type, hyperparams, hardware_specs, dataset):

# Initialisation de la configuration système

system = SystemSetup(hardware_specs)

# Collecte des données de profilage

data = DataCollection(model_type, hyperparams, dataset)

# Entraînement du modèle de prédiction avec XGBoost

predictor = XGBoostTrainer(data)

# Prédiction de l'utilisation des ressources et du temps

predictions = predictor.predict(system)

return predictions

4. Résultats Expérimentaux

Les expériences initiales ont impliqué plus de 3 000 exécutions avec des configurations variées. En utilisant XGBoost pour la prédiction, nous avons obtenu une RMSE normalisée de 0,001, une amélioration significative par rapport aux MLP avec plus de 4 millions de paramètres. Cela démontre l'efficacité de notre approche de profilage pour optimiser l'allocation des ressources et améliorer les performances de l'IA en périphérie.

La Figure 1 illustre la feuille de route de la recherche, montrant le flux allant de la configuration du système de l'appareil à l'ordonnancement des tâches, mettant en évidence l'intégration des données de profilage dans les politiques de délégation.

5. Analyse Originale

Cette recherche présente une avancée critique dans l'IA en périphérie en abordant l'hétérogénéité des dispositifs périphériques grâce à un profilage systématique des modèles d'IA. L'approche s'aligne sur la vision de l'AI-RAN Alliance pour les réseaux 6G, où une délégation de calcul efficace est essentielle pour les applications sensibles à la latence comme les véhicules autonomes et la réalité augmentée. L'utilisation de XGBoost pour la prédiction des ressources, atteignant une RMSE normalisée de 0,001, surpasse les méthodes traditionnelles comme les MLP, similaire aux améliorations observées avec CycleGAN pour les tâches de traduction d'image (Zhu et al., 2017). Cette efficacité est cruciale pour les systèmes en temps réel où les contraintes de ressources sont primordiales, comme le notent les études du IEEE Edge Computing Consortium.

La méthodologie de profilage capture les dépendances entre les hyperparamètres du modèle, les spécifications matérielles et les métriques de performance, permettant un ordonnancement prédictif. Cela est similaire aux techniques d'apprentissage par renforcement dans les systèmes distribués, comme celles explorées par Google Research pour l'optimisation des centres de données. Cependant, l'accent mis sur les environnements edge en bare-metal ajoute une couche de complexité due à la variabilité matérielle, souvent négligée dans les systèmes d'IA cloud homogènes. L'intégration avec l'infrastructure 6G promet une confidentialité améliorée et une latence réduite, soutenant les applications émergentes comme le Métavers. Les travaux futurs pourraient explorer l'intégration de l'apprentissage fédéré, comme proposé par Konečný et al. (2016), pour améliorer davantage la confidentialité des données tout en maintenant la précision du profilage.

Globalement, cette recherche comble une lacune dans la littérature sur l'IA en périphérie en fournissant une solution évolutive pour les systèmes hétérogènes, avec des impacts potentiels sur la standardisation de la 6G et les frameworks d'informatique en périphérie. Les résultats empiriques provenant de 3 000 exécutions valident l'approche, établissant une base pour la délégation adaptative dans des environnements dynamiques.

6. Applications Futures et Orientations

Les applications futures incluent des expériences de Métavers améliorées, la surveillance sanitaire à distance et des essaims de drones autonomes. Les orientations impliquent l'intégration de l'apprentissage fédéré pour la confidentialité, l'exploitation du découpage réseau de la 6G pour l'allocation dynamique des ressources, et l'extension du profilage pour inclure les architectures de calcul neuromorphique.

7. Références

- AI-RAN Alliance. (2023). AI-RAN Working Groups. Récupéré de https://ai-ran.org/working-groups/

- Zhu, J. Y., Park, T., Isola, P., & Efros, A. A. (2017). Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks. In IEEE International Conference on Computer Vision (ICCV).

- Konečný, J., McMahan, H. B., Yu, F. X., Richtárik, P., Suresh, A. T., & Bacon, D. (2016). Federated Learning: Strategies for Improving Communication Efficiency. arXiv preprint arXiv:1610.05492.

- IEEE Edge Computing Consortium. (2022). Edge Computing Standards and Practices. Récupéré de https://www.ieee.org