Indice dei Contenuti

- 1. Introduzione

- 2. Roadmap della Ricerca

- 3. Dettagli Tecnici

- 4. Risultati Sperimentali

- 5. Analisi Originale

- 6. Applicazioni Future e Direzioni

- 7. References

1. Introduzione

La rapida crescita di applicazioni AI per utenti finali, come il riconoscimento di immagini in tempo reale e l'AI generativa, ha generato elevate esigenze di dati ed elaborazione che spesso superano le capacità dei dispositivi. L'Edge AI affronta queste sfide scaricando l'elaborazione verso il bordo della rete, dove può avvenire l'elaborazione AI accelerata via hardware. Questo approccio è parte integrante di AI e RAN, un componente chiave delle future reti 6G come delineato dall'AI-RAN Alliance. Nel 6G, l'integrazione dell'AI tra dispositivi edge-RAN ed extreme-edge supporterà una distribuzione efficiente dei dati e tecniche di AI distribuita, migliorando la privacy e riducendo la latenza per applicazioni come il Metaverso e la chirurgia remota.

Nonostante questi vantaggi, l'Edge AI affronta delle sfide. La limitata disponibilità di risorse al bordo può ostacolare le prestazioni durante scaricamenti simultanei. Inoltre, l'ipotesi di un'architettura di sistema omogenea nella letteratura esistente è irrealistica, poiché i dispositivi edge variano notevolmente in velocità di processore e architetture (ad esempio, 1.5GHz vs 3.5GHz, o X86 vs ARM), con un impatto sull'elaborazione delle attività e sull'utilizzo delle risorse.

2. Roadmap della Ricerca

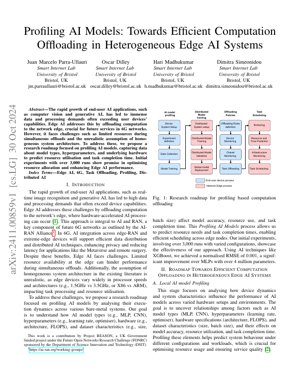

La nostra roadmap di ricerca si concentra sul profiling dei modelli di IA per ottimizzare il computation offloading in sistemi eterogenei di edge AI. Il processo comprende system setup, AI model profiling, distributed model training, offloading policies e task scheduling.

2.1 Profilazione dei Modelli di IA Locali

Questa fase analizza come le dinamiche del dispositivo e le caratteristiche del sistema influenzano le prestazioni dei modelli AI su diverse configurazioni hardware. L'obiettivo è individuare le relazioni tra fattori come i tipi di modelli AI (MLP, CNN), gli iperparametri (learning rate, optimizer), le specifiche hardware (architettura, FLOPS) e le caratteristiche dei dataset (dimensione, batch size), e i loro effetti su accuratezza del modello, utilizzo delle risorse e tempo di completamento del task.

2.2 Previsione delle Risorse e dei Tempi

Utilizzando i dati di profilazione, prevediamo le necessità di risorse e i tempi di completamento delle attività per consentire una pianificazione efficiente tra i nodi periferici. Tecniche come XGBoost sono impiegate per raggiungere un'elevata accuratezza predittiva.

2.3 Scarico e Pianificazione dei Task

Sulla base delle previsioni, i task vengono trasferiti e schedulati per ottimizzare l'allocazione delle risorse e migliorare le prestazioni di Edge AI in ambienti eterogenei.

3. Dettagli Tecnici

3.1 Formalizzazioni Matematiche

Le formule chiave includono la RMSE normalizzata per l'accuratezza predittiva: $NRMSE = \frac{\sqrt{\frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2}}{y_{\max} - y_{\min}}$, dove $y_i$ è il valore reale, $\hat{y}_i$ è il valore predetto e $y_{\max} - y_{\min}$ è l'intervallo dei valori reali. L'utilizzo delle risorse è modellato come $R = f(M, H, D)$, dove $M$ è il tipo di modello, $H$ sono le specifiche hardware e $D$ sono le caratteristiche del dataset.

3.2 Implementazione del Codice

Pseudocodice per il processo di profilazione:

def ai_model_profiling(model_type, hyperparams, hardware_specs, dataset):

4. Risultati Sperimentali

Gli esperimenti iniziali hanno coinvolto oltre 3.000 esecuzioni con configurazioni variate. Utilizzando XGBoost per le previsioni, abbiamo ottenuto un RMSE normalizzato di 0.001, un miglioramento significativo rispetto alle MLP con oltre 4 milioni di parametri. Ciò dimostra l'efficacia del nostro approccio di profilazione nell'ottimizzare l'allocazione delle risorse e nel migliorare le prestazioni di Edge AI.

La Figura 1 illustra la roadmap della ricerca, mostrando il flusso dalla configurazione del sistema del dispositivo alla pianificazione delle attività, evidenziando l'integrazione dei dati di profilazione nelle politiche di offloading.

5. Analisi Originale

Questa ricerca rappresenta un progresso cruciale nell'Edge AI affrontando l'eterogeneità dei dispositivi edge attraverso la profilazione sistematica dei modelli di IA. L'approccio si allinea con la visione dell'AI-RAN Alliance per le reti 6G, dove l'offloading efficiente dei calcoli è essenziale per applicazioni sensibili alla latenza come veicoli autonomi e realtà aumentata. L'utilizzo di XGBoost per la previsione delle risorse, che raggiunge un RMSE normalizzato di 0.001, supera i metodi tradizionali come le MLP, simile ai miglioramenti osservati in CycleGAN per attività di traduzione di immagini (Zhu et al., 2017). Questa efficienza è cruciale per sistemi in tempo reale dove i vincoli delle risorse sono primari, come notato negli studi dell'IEEE Edge Computing Consortium.

La metodologia di profilazione cattura le dipendenze tra gli iperparametri del modello, le specifiche hardware e le metriche prestazionali, consentendo una pianificazione predittiva. Ciò è simile alle tecniche di apprendimento per rinforzo nei sistemi distribuiti, come quelle esplorate da Google Research per l'ottimizzazione dei data center. Tuttavia, l'attenzione agli ambienti edge bare-metal aggiunge un livello di complessità dovuto alla variabilità hardware, spesso trascurata nei sistemi di IA cloud omogenei. L'integrazione con l'infrastruttura 6G promette una maggiore privacy e una latenza ridotta, supportando applicazioni emergenti come il Metaverso. Il lavoro futuro potrebbe esplorare l'integrazione dell'apprendimento federato, come proposto da Konečný et al. (2016), per migliorare ulteriormente la privacy dei dati mantenendo l'accuratezza della profilazione.

Nel complesso, questa ricerca colma una lacuna nella letteratura sull'Edge AI fornendo una soluzione scalabile per sistemi eterogenei, con potenziali impatti sulla standardizzazione 6G e sui framework di edge computing. I risultati empirici di 3.000 esecuzioni convalidano l'approccio, gettando le basi per lo scaricamento adattivo in ambienti dinamici.

6. Applicazioni Future e Direzioni

Le applicazioni future includono esperienze nel Metaverso potenziate, monitoraggio sanitario remoto e sciami di droni autonomi. Le direzioni di sviluppo prevedono l'integrazione del federated learning per la privacy, lo sfruttamento del network slicing 6G per l'allocazione dinamica delle risorse e l'ampliamento del profiling per includere architetture di computazione neuromorfica.

7. References

- AI-RAN Alliance. (2023). AI-RAN Working Groups. Recuperato da https://ai-ran.org/working-groups/

- Zhu, J. Y., Park, T., Isola, P., & Efros, A. A. (2017). Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks. In IEEE International Conference on Computer Vision (ICCV).

- Konečný, J., McMahan, H. B., Yu, F. X., Richtárik, P., Suresh, A. T., & Bacon, D. (2016). Federated Learning: Strategies for Improving Communication Efficiency. arXiv preprint arXiv:1610.05492.

- IEEE Edge Computing Consortium. (2022). Edge Computing Standards and Practices. Recuperato da https://www.ieee.org