Table of Contents

- 1. はじめに

- 2. 研究ロードマップ

- 3. Technical Details

- 4. Experimental Results

- 5. Original Analysis

- 6. Future Applications and Directions

- 7. References

1. はじめに

リアルタイム画像認識や生成AIといったエンドユーザーAIアプリケーションの急速な発展により、デバイスの能力を超える高いデータ処理要求が生じている。Edge AIは、ハードウェア加速によるAI処理が可能なネットワークエッジへの計算オフロードによってこれらの課題に対処する。このアプローチは、AI-RAN Allianceが示す将来の6Gネットワークの重要構成要素であるAIとRANに不可欠な要素となっている。6Gでは、エッジ-RANから極限エッジデバイスにわたるAI統合により、効率的なデータ分散と分散型AI技術を実現し、Metaverseや遠隔手術などのアプリケーションにおけるプライバシー保護と低遅延化を促進する。

こうした利点にも関わらず、Edge AIには課題が存在する。エッジにおけるリソース制約は、同時オフロード時の性能を阻害する可能性がある。さらに、既存研究で想定されている均一なシステムアーキテクチャは非現実的であり、エッジデバイスはプロセッサ速度(1.5GHzと3.5GHz)やアーキテクチャ(X86対ARM)において大きく異なり、これがタスク処理とリソース利用率に影響を与える。

2. 研究ロードマップ

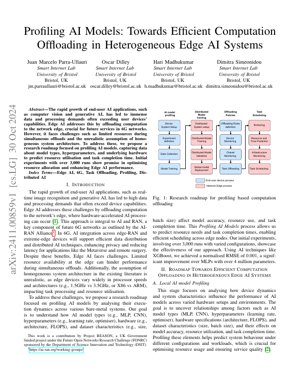

本研究のロードマップは、異種混合エッジAIシステムにおける計算オフロード最適化のためAIモデルのプロファイリングに焦点を当てる。プロセスは、システム設定、AIモデルプロファイリング、分散型モデル訓練、オフロードポリシー、タスクスケジューリングを含む。

2.1 ローカルAIモデルのプロファイリング

この段階では、デバイスの動的特性とシステム特性が、様々なハードウェア構成におけるAIモデルのパフォーマンスにどのように影響するかを分析します。目的は、AIモデルの種類(MLP、CNN)、ハイパーパラメータ(学習率、オプティマイザ)、ハードウェア仕様(アーキテクチャ、FLOPS)、データセット特性(サイズ、バッチサイズ)などの要因と、それらがモデルの精度、リソース利用率、タスク完了時間に及ぼす影響との間の関係を明らかにすることです。

2.2 リソースと時間の予測

プロファイリングデータを活用し、リソース需要とタスク完了時間を予測することで、エッジノード間での効率的なスケジューリングを実現します。XGBoostなどの技術を採用し、高い予測精度を達成しています。

2.3 タスクオフローディングとスケジューリング

予測に基づき、タスクのオフロードとスケジューリングを実行し、リソース配分を最適化することで、異種混在環境におけるEdge AIのパフォーマンス向上を実現します。

3. Technical Details

3.1 Mathematical Formulations

主な数式には、予測精度の正規化RMSEが含まれる:$NRMSE = \frac{\sqrt{\frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2}}{y_{\max} - y_{\min}}$。ここで$y_i$は実測値、$\hat{y}_i$は予測値、$y_{\max} - y_{\min}$は実測値のレンジを表す。リソース使用率は$R = f(M, H, D)$でモデル化され、$M$はモデル種類、$H$はハードウェア仕様、$D$はデータセット特性を示す。

3.2 コード実装

プロファイリング処理の疑似コード:

def ai_model_profiling(model_type, hyperparams, hardware_specs, dataset):

4. Experimental Results

Initial experiments involved over 3,000 runs with varied configurations. Using XGBoost for prediction, we achieved a normalized RMSE of 0.001, a significant improvement over MLPs with over 4 million parameters. This demonstrates the effectiveness of our profiling approach in optimizing resource allocation and enhancing Edge AI performance.

Figure 1は、デバイスシステムの設定からタスクスケジューリングまでの流れを示し、プロファイリングデータのオフロードポリシーへの統合を強調した研究ロードマップを図示しています。

5. Original Analysis

本研究は、体系的なAIモデルプロファイリングを通じてエッジデバイスの異種性に対処することで、Edge AIにおける重要な進歩を提示しています。このアプローチは、自律走行車や拡張現実のような遅延に敏感なアプリケーションにおいて効率的な計算オフロードが不可欠である6GネットワークのAI-RAN Allianceのビジョンに沿っています。正規化RMSE 0.001を達成したXGBoostを用いたリソース予測は、MLPのような従来手法を凌駕し、画像変換タスクにおけるCycleGANの改善(Zhu et al., 2017)と同様の進歩を示しています。IEEE Edge Computing Consortiumの研究で指摘されているように、リソース制約が最重要であるリアルタイムシステムにおいて、この効率性は極めて重要です。

プロファイリング手法は、モデルのハイパーパラメータ、ハードウェア仕様、パフォーマンス指標間の依存関係を捉え、予測的スケジューリングを可能にする。これは、Google Researchがデータセンター最適化で探求したような、分散システムにおける強化学習技術に類似する。しかし、ベアメタルエッジ環境への焦点は、均質なクラウドAIシステムでは軽視されがちなハードウェア多様性により、複雑さの層を追加する。6Gインフラとの統合は、メタバースのような新興アプリケーションを支援し、プライバシー強化と低遅延を約束する。今後の課題としては、Konečný et al. (2016)が提案した連合学習の統合を探求し、プロファイリング精度を維持しつつデータプライバシーをさらに改善できる。

全体として、本研究は異種システムに対するスケーラブルなソリューションを提供し、6G標準化とエッジコンピューティングフレームワークに潜在的な影響を与えることで、Edge AI文献のギャップを埋める。3,000回の実行による実証結果はこのアプローチを検証し、動的環境における適応的オフローディングの基盤を築く。

6. Future Applications and Directions

将来の応用分野には、強化されたメタバース体験、遠隔ヘルスケアモニタリング、自律型ドローンの群れ制御が含まれる。研究方向として、プライバシー保護のための連合学習の統合、動的リソース割り当てにおける6Gネットワークスライシングの活用、ニューロモルフィックコンピューティングアーキテクチャを含むプロファイリングの拡大が挙げられる。

7. References

- AI-RAN Alliance. (2023). AI-RANワーキンググループ. https://ai-ran.org/working-groups/ より取得。

- Zhu, J. Y., Park, T., Isola, P., & Efros, A. A. (2017). Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks. In IEEE International Conference on Computer Vision (ICCV).

- Konečný, J., McMahan, H. B., Yu, F. X., Richtárik, P., Suresh, A. T., & Bacon, D. (2016). Federated Learning: Strategies for Improving Communication Efficiency. arXiv preprint arXiv:1610.05492.

- IEEE Edge Computing Consortium. (2022). エッジコンピューティング標準と実践. Retrieved from https://www.ieee.org