Índice

- 1. Introdução

- 2. Roteiro de Investigação

- 3. Detalhes Técnicos

- 4. Resultados Experimentais

- 5. Análise Original

- 6. Aplicações e Direções Futuras

- 7. Referências

1. Introdução

O rápido crescimento de aplicações de IA para utilizadores finais, como o reconhecimento de imagem em tempo real e a IA generativa, levou a elevadas exigências de dados e processamento que frequentemente excedem as capacidades dos dispositivos. A IA na Borda (Edge AI) aborda estes desafios ao descarregar a computação para a periferia da rede, onde pode ocorrer o processamento de IA acelerado por hardware. Esta abordagem é integral para a IA e RAN, um componente fundamental das futuras redes 6G, conforme delineado pela AI-RAN Alliance. Na 6G, a integração de IA através de dispositivos edge-RAN e extreme-edge suportará uma distribuição eficiente de dados e técnicas de IA distribuída, melhorando a privacidade e reduzindo a latência para aplicações como o Metaverso e a cirurgia remota.

Apesar destes benefícios, a IA na Borda enfrenta desafios. A limitada disponibilidade de recursos na borda pode prejudicar o desempenho durante descargas simultâneas. Adicionalmente, a suposição de uma arquitetura de sistema homogénea na literatura existente é irrealista, uma vez que os dispositivos de borda variam amplamente em velocidades e arquiteturas de processador (por exemplo, 1.5GHz vs 3.5GHz, ou X86 vs ARM), impactando o processamento de tarefas e a utilização de recursos.

2. Roteiro de Investigação

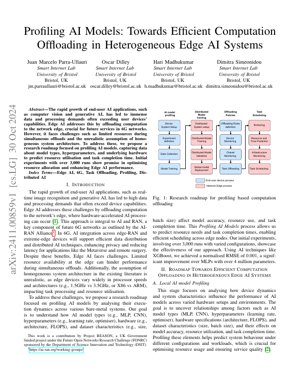

O nosso roteiro de investigação foca-se na perfilização de modelos de IA para otimizar a descarga de computação em sistemas heterogéneos de IA na borda. O processo envolve a configuração do sistema, a perfilização do modelo de IA, o treino distribuído do modelo, políticas de descarga e o agendamento de tarefas.

2.1 Perfilização Local de Modelos de IA

Esta etapa analisa como a dinâmica do dispositivo e as características do sistema influenciam o desempenho do modelo de IA em várias configurações de hardware. O objetivo é descobrir relações entre fatores como tipos de modelo de IA (MLP, CNN), hiperparâmetros (taxa de aprendizagem, otimizador), especificações de hardware (arquitetura, FLOPS) e características do conjunto de dados (tamanho, tamanho do lote), e os seus efeitos na precisão do modelo, utilização de recursos e tempo de conclusão da tarefa.

2.2 Previsão de Recursos e Tempo

Utilizando dados de perfilização, prevemos as necessidades de recursos e os tempos de conclusão de tarefas para permitir um agendamento eficiente entre os nós de borda. Técnicas como o XGBoost são empregues para alcançar uma alta precisão de previsão.

2.3 Descarga e Agendamento de Tarefas

Com base nas previsões, as tarefas são descarregadas e agendadas para otimizar a alocação de recursos e melhorar o desempenho da IA na Borda em ambientes heterogéneos.

3. Detalhes Técnicos

3.1 Formulações Matemáticas

Fórmulas-chave incluem o RMSE normalizado para a precisão da previsão: $NRMSE = \frac{\sqrt{\frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2}}{y_{\max} - y_{\min}}$, onde $y_i$ é o valor real, $\hat{y}_i$ é o valor previsto, e $y_{\max} - y_{\min}$ é o intervalo dos valores reais. A utilização de recursos é modelada como $R = f(M, H, D)$, onde $M$ é o tipo de modelo, $H$ são as especificações de hardware e $D$ são as características do conjunto de dados.

3.2 Implementação de Código

Pseudocódigo para o processo de perfilização:

def ai_model_profiling(model_type, hyperparams, hardware_specs, dataset):

# Inicializar a configuração do sistema

system = SystemSetup(hardware_specs)

# Recolher dados de perfilização

data = DataCollection(model_type, hyperparams, dataset)

# Treinar modelo de previsão usando XGBoost

predictor = XGBoostTrainer(data)

# Prever utilização de recursos e tempo

predictions = predictor.predict(system)

return predictions

4. Resultados Experimentais

As experiências iniciais envolveram mais de 3.000 execuções com configurações variadas. Utilizando o XGBoost para previsão, alcançámos um RMSE normalizado de 0.001, uma melhoria significativa em comparação com MLPs com mais de 4 milhões de parâmetros. Isto demonstra a eficácia da nossa abordagem de perfilização na otimização da alocação de recursos e na melhoria do desempenho da IA na Borda.

A Figura 1 ilustra o roteiro de investigação, mostrando o fluxo desde a configuração do sistema do dispositivo até ao agendamento de tarefas, destacando a integração dos dados de perfilização nas políticas de descarga.

5. Análise Original

Esta investigação apresenta um avanço crítico na IA na Borda ao abordar a heterogeneidade dos dispositivos de borda através de uma perfilização sistemática de modelos de IA. A abordagem está alinhada com a visão da AI-RAN Alliance para as redes 6G, onde a descarga eficiente de computação é essencial para aplicações sensíveis à latência, como veículos autónomos e realidade aumentada. A utilização do XGBoost para a previsão de recursos, alcançando um RMSE normalizado de 0.001, supera métodos tradicionais como MLPs, semelhante a melhorias observadas no CycleGAN para tarefas de tradução de imagem (Zhu et al., 2017). Esta eficiência é crucial para sistemas em tempo real onde as restrições de recursos são primordiais, conforme observado em estudos do IEEE Edge Computing Consortium.

A metodologia de perfilização captura dependências entre hiperparâmetros do modelo, especificações de hardware e métricas de desempenho, permitindo um agendamento preditivo. Isto é semelhante a técnicas de aprendizagem por reforço em sistemas distribuídos, como as exploradas pela Google Research para a otimização de centros de dados. No entanto, o foco em ambientes de borda de bare-metal adiciona uma camada de complexidade devido à variabilidade do hardware, que é frequentemente ignorada em sistemas de IA homogéneos baseados na cloud. A integração com a infraestrutura 6G promete uma privacidade melhorada e uma latência reduzida, suportando aplicações emergentes como o Metaverso. Trabalhos futuros poderão explorar a integração da aprendizagem federada, conforme proposto por Konečný et al. (2016), para melhorar ainda mais a privacidade dos dados, mantendo a precisão da perfilização.

No geral, esta investigação preenche uma lacuna na literatura da IA na Borda, fornecendo uma solução escalável para sistemas heterogéneos, com impactos potenciais na padronização da 6G e em estruturas de computação na borda. Os resultados empíricos de 3.000 execuções validam a abordagem, estabelecendo uma base para a descarga adaptativa em ambientes dinâmicos.

6. Aplicações e Direções Futuras

As aplicações futuras incluem experiências de Metaverso melhoradas, monitorização remota de saúde e enxames de drones autónomos. As direções envolvem a integração da aprendizagem federada para privacidade, a utilização do fatiamento de rede 6G para alocação dinâmica de recursos e a expansão da perfilização para incluir arquiteturas de computação neuromórfica.

7. Referências

- AI-RAN Alliance. (2023). AI-RAN Working Groups. Obtido de https://ai-ran.org/working-groups/

- Zhu, J. Y., Park, T., Isola, P., & Efros, A. A. (2017). Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks. In IEEE International Conference on Computer Vision (ICCV).

- Konečný, J., McMahan, H. B., Yu, F. X., Richtárik, P., Suresh, A. T., & Bacon, D. (2016). Federated Learning: Strategies for Improving Communication Efficiency. arXiv preprint arXiv:1610.05492.

- IEEE Edge Computing Consortium. (2022). Edge Computing Standards and Practices. Obtido de https://www.ieee.org